Multisearch, o funcție Google Lens care poate căuta imagini și text simultan, va fi în curând disponibilă pe scară largă după ce va ajunge în SUA ca versiune beta la mai târziu în acest an. Google spune că multisearch se va extinde la peste 70 de limbi în următoarele luni. Compania a făcut anunțul la un eveniment axat pe Căutare.

În plus, funcția Aproape de mine, pe care Google a dezvăluit-o la I/O în luna mai, va ajunge în SUA în limba engleză în această toamnă. Acest lucru se leagă de căutarea multiplă, cu ideea de a face mai ușor pentru oameni să afle mai multe detalii despre afacerile locale.

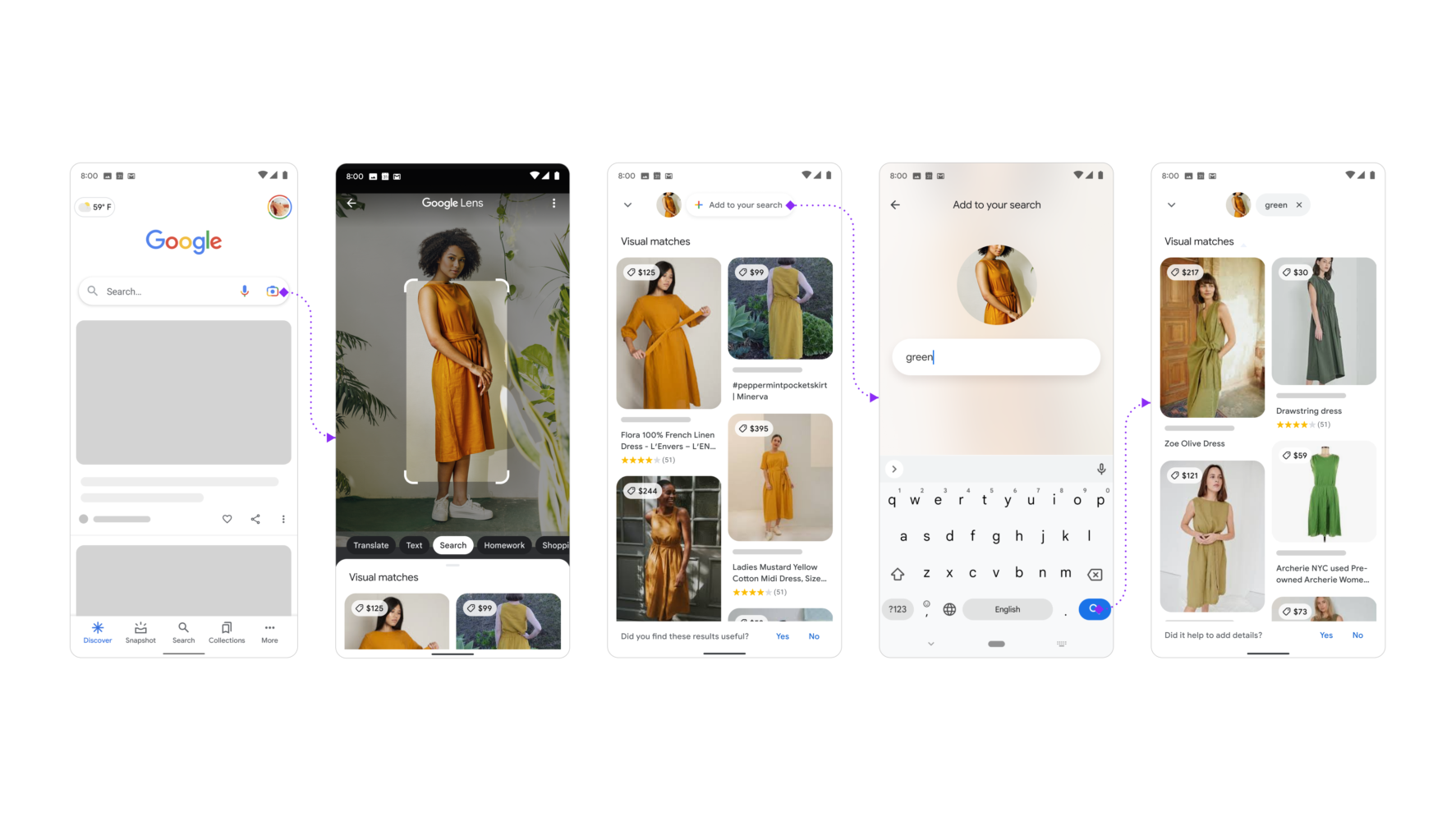

Lens Multisearch se referă în mare parte la a permite oamenilor să-și îndrepte camera către ceva și să întrebe despre asta în timp ce folosesc aplicația Google. Puteți să vă orientați telefonul către un magazin și să solicitați detalii despre acesta, de exemplu, sau să întrebați despre o captură de ecran a oricărui articol necunoscut, cum ar fi un articol de îmbrăcăminte.

Puteți, de asemenea, să căutați cum se numește un anumit produs alimentar, cum ar fi supă de găluște de supă, și să vedeți ce restaurante din jurul vostru îl oferă.

De asemenea, pe partea Lens, vor exista unele schimbări când vine vorba de traduceri în realitate augmentată. Google folosește acum aceeași tehnologie de inteligență artificială pe care o folosește pentru caracteristica Magic Eraser a Pixel 6, pentru a face să pară ca și cum ar înlocui textul original, în loc să suprapună traducerea deasupra. Ideea este de a face traducerile să pară mai fluide și mai naturale.

Google adaugă, de asemenea, comenzi rapide în partea de jos a barei de căutare în aplicația sa iOS, astfel încât veți găsi mai ușor funcții precum traducerea textului cu camera dvs., și traducerea textului în capturi de ecran.